Sarah Katz, 27 tuổi, làm việc dưới vai trò một người phê duyệt nội dung tại trụ sở chính của Facebook ở Menlo Park, California, thông qua một nhà thầu bên thứ ba có tên Vertisystem trong suốt 8 tháng năm 2016. Công việc của cô rất đơn giản: xác định xem những bài đăng được báo cáo tới Facebook có vi phạm các tiêu chuẩn cộng đồng chi tiết của công ty này hay không.

Để dễ hình dung, điều này có nghĩa là xem tất cả các nội dung mới và có khả năng là nội dung không lành mạnh được báo cáo mỗi 10 giây và đưa ra quyết định nhanh chóng rằng chúng có nên bị gỡ không. Các bài đăng cần xem lại được gọi là “vé” (ticket) và có khoảng 8.000 “vé” mỗi ngày.

Để đương đầu với chúng, Facebook có khoảng 4.500 quản trị viên như Katz và vào tháng 7 năm ngoái, công ty này còn công bố sẽ chiêu mộ thêm khoảng 3.000 người nữa để chiến đấu với những góc khuất và tối tăm nhất cuả Facebook. Facebook cũng đang tập trung vào phát triển trí tuệ nhân tạo để lọc các nội dung phá luật.

Vào tháng 5 vừa qua, Facebook công bố nhiều chi tiết về các nội dung bị cấm trong một bản báo cáo minh bạch. Theo đó, ông lớn mạng xã hội cho biết chỉ trong ba tháng đầu năm đã “xử lý” 21 triệu bài đăng chứa các nội dung tình dục và khoả thân cùng 3,4 triệu nội dung bạo lực. Hàng triệu nội dung với ngôn ngữ thù hằn, spam và nội dung khủng bố cũng được gỡ bỏ.

Các quản trị viên phải kí văn bản trách nhiệm về nội dung khó chịu

|

|

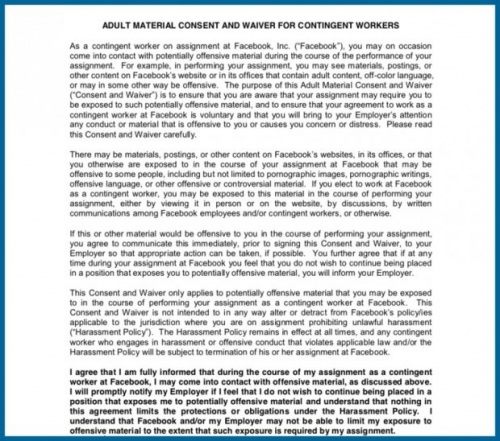

Các quản trị viên nội dung sẽ bắt đầu hành trình của mình bằn cách kí vào một văn bản trách nhiệm, trong đó về cơ bản sẽ xác nhận việc họ “dốc lòng” xem những nội dung gây khó chịu. Nó cũng được thiết kế để bảo vệ Facebook khỏi những rắc rối liên quan đến luật pháp.

Văn bản mà Katz kí nói rằng các quản trị viên phải tiếp cận với các nội dung “có thể xúc phạm đối với một số người,” bao gồm cả những hình ảnh khiêu dâm. Nó nói thêm rằng các nhân viên cần “thông báo ngay lập tức” với Facebook “nếu họ không muốn tiếp tục làm nữa.”

“Facebook có hàng tỷ người dùng và nhiều người không biết dùng mạng xã hội này sao cho hợp lý, vì thế có rất nhiều nội dung khiêu dâm, làm “chuyện ấy” với động vật, hình ảnh bạo lực,” Katz nói với Business Insider. “Có rất nhiều nội dung bạn không bao giờ nghĩ rằng lại có thể được chia sẻ trên Facebook.”

Katz làm việc trong một văn phòng với không gian mở ở Manlo Park nơi đồ ăn được phát miễn phí và đồng nghiệp khá thân thiện. Họ được xử lý các dòng nội dung được chuyển đến cho riêng mình để phê duyệt và khi dòng thông tin ồ ạt, Katz sẽ đưa ra quyết định chỉ trong vài giây.

Nếu chỉ tiêu “vé” không đạt, hậu quả sẽ đến. Không đạt mục tiêu “một hay hai lần”, bạn sẽ bị cảnh cáo, Katz nói; hơn ba lần, “bạn có thể sẽ bị cho thôi việc.” Katz chia sẻ cô chưa bao giờ được chứng kiến điều này nhưng nó là một thứ các nhân viên đều nắm được.

“Đây là một công việc buồn tẻ và đơn điệu sau một thời gian” cô nói. “Bạn sẽ chai lì cảm xúc với các hình ảnh đáng sợ khi bạn nhìn thấy nó quá nhiều. Nhiều nội dung còn có khi được chia sẻ lại.”

Hình ảnh đáng sợ liên tục xuất hiện trở lại

|

Katz nhớ lại có lần một hình ảnh và video đáng sợ liên tục xuất hiện trong số bài đăng cô phải xử lý. |

Cô nói nó xuất hiện hai đứa trẻ tầm từ 9 đến 12 tuổi không mặc gì từ eo trở xuống và chạm vào người nhau. Rõ ràng là, Katz nói, có ai đó đằng sau camera đã bảo chúng làm như vậy. “Nó bị gỡ rồi lại quay lại. Nhiều lần trong một này. Mỗi lần vị trí của người dùng chia sẻ lại khác nhau - có lần từ Pakistan, nhưng lần khác lại từ Mỹ. Rất khó để xác định được nguồn tin ban đầu.”

Thời điểm đó, Katz cảm thấy khó chịu khi cô được yêu cầu không báo cáo tài khoản vi phạm. “Nếu tài khoản người dùng mới mở ít hơn 30 ngày, chúng tôi sẽ dừng kích hoạt nó như một tài khoản giả mạo,” cô nói. “Nếu trên 30 ngày, chúng tôi đơn thuần xoá bỏ nội dung và vẫn để tài khoản hoạt động.” Trải nghiệm của Katz khiến nhiều người hoài nghi về những nỗ lực Facebook đang thực hiện để chống lại việc lạm dụng hình ảnh trẻ em trên Facebook.

Năm 2011, Facebook kí một thoả thuận với Microsoft để sử dụng công nghệ PhotoDNA. Công nghệ này được thiết kế để quét tất cả các hình ảnh trên Facebook và Instagram, đánh dấu các hình ảnh ấu dâm đã được phát hiện trước và chặn đăng tải lại. Ngoài ra, quản trị viên Facebook cũng được đào tạo để xác nhận và chuyển các nội dung đó nội bộ mỗi khi nhìn thấy.

“Chúng tôi không dung thứ cho việc tải nội dung ấu dâm lên Facebook và sẽ quyết liệt chặn và xoá các nội dung như thế,” một người phát ngôn Facebook từng chia sẻ.

Katz chia sẻ cô không thấy bất kì điều gì ổn định lúc cô đang làm việc tại đây vào năm 2016. “Facebook có thể có chính sách về những gì bạn nên báo cáo, nhưng trở lại thời điểm đó thì không,” cô chia sẻ. Business Insider cho biết Facebook từ chối bình luận về những khác biệt giữa những gì họ tuyên bố và câu chuyện của Katz.

Những sắc thái trong quan điểm của con người

|

|

Katz giờ là một phân tích viên an ninh số cho công ty điện toán đám mây ServiceNow và đã viết một cuốn sách khoa học viễn tưởng có tên Apex Five. Cuốn sách này lấy cảm hứng từ quãng thời gian cô làm việc tại Facebook. Katz vẫn cảm thấy tích cực về công việc này bởi tất cả những khó khăn đều không quan trọng bằng việc những gì cô làm đang bảo vệ người dùng.

“Cần phải có con mắt của con người dành cho công việc này, không phải thứ gì cũng chuyển cho trí tuệ nhân tạo thực hiện là xong,” Katz nhận định. “Chúng ta sẽ mãi mãi có được những sắc thái trong quan điểm như vậy. Trí tuệ nhân tạ có thể giúp theo dõi tất cả các nội dung từ hàng tỷ người dùng. Yếu tố con người vẫn cần được trọng dụng và chúng tôi đang làm tốt công việc đó.”

Vì thế, Katz cũng thúc giục các ông lớn công nghệ nhìn nhận nghề quản trị nội dung thành một sự nghiệp chứ không phải một công việc ngắn hạn.

Tác giả: Lê Nam Khánh

Nguồn tin: saostar.vn